Gen AI Ops: Arquitectura y puesta en marcha de procesos de IA

Gen AI Ops: Arquitectura y puesta en marcha de procesos de IA

LLMOPS y Gen AI Ops: claves para la implementación y escalabilidad de modelos de lenguaje generativos

La inteligencia artificial generativa y los modelos de lenguaje (LLMs) han avanzado muchísimo en el último año, revolucionando industrias enteras y dejando al mundo sorprendido con cada nuevo avance. Sin embargo, esto es una carrera de fondo. Aunque la democratización de estas tecnologías, impulsada en gran parte por la llegada de ChatGPT, ha permitido que cualquier persona, incluso sin conocimientos técnicos, pueda utilizarlas con facilidad, el verdadero reto está en su implementación y operación a gran escala. Es aquí donde entran en juego conceptos como Gen AI Ops y LLMOPS, metodologías que no solo facilitan el despliegue de modelos, sino que también optimizan su mantenimiento y escalabilidad en entornos reales. En este artículo, exploraremos los elementos clave de los LLMOPS, como el fine-tuning, la retrieval-augmented generation (RAG) y los AI agents, fundamentales para la gestión y el éxito de estos sistemas avanzados.

LLMOps: Qué es y por qué es clave para escalar, controlar y medir LLMs en producción

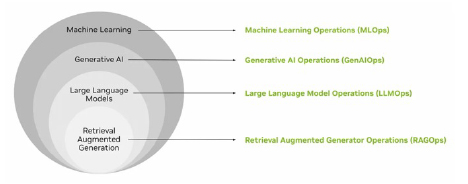

Mientras que MLOps sentó las bases para la implementación de modelos de machine learning tradicionales, LLMOps nace como un conjunto de prácticas diseñadas para enfrentar los desafíos de poner en producción, medir y operar los LLMs. Su importancia radica en la capacidad de optimizar su despliegue, monitoreo y mantenimiento, garantizando eficiencia y control en entornos de producción.

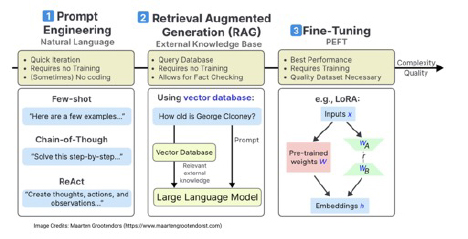

Fine-Tuning: Personalización sin partir de cero

En lugar de entrenar un modelo desde el inicio, el fine-tuning permite adaptar modelos preentrenados a tareas específicas sin necesidad de modificar todos sus parámetros. Métodos como LoRA (Low-Rank Adaptation) y adapter layers optimizan este proceso, reduciendo el costo computacional y facilitando la adaptación del modelo a un vocabulario o contexto particular. Esto permite especializar los LLMs en necesidades concretas sin requerir grandes infraestructuras ni largos tiempos de entrenamiento.

Retrieval-Augmented Generation (RAG): Información precisa y actualizada en tiempo real

Uno de los mayores desafíos en el uso de LLMs es dotarlos del contexto específico de cada empresa y garantizar que el conocimiento utilizado esté siempre actualizado. RAG (Retrieval-Augmented Generation) aborda este problema combinando la generación de texto con la recuperación de información en tiempo real desde bases de conocimiento propias.

Gracias a esta técnica, los modelos pueden ofrecer respuestas más precisas y relevantes, asegurando que aprovechan su capacidad de comprensión e interpretación del lenguaje natural sin perder de vista la información clave del negocio.

AI Agents: Automatización avanzada con modelos LLM

Los AI agents son sistemas autónomos que integran múltiples modelos de lenguaje con diversas herramientas y fuentes de datos. Su objetivo es ejecutar tareas complejas de manera eficiente, combinando habilidades como el procesamiento de información, el razonamiento y la toma de decisiones. En el ámbito de la inteligencia artificial generativa (GenAI), estos agentes se han convertido en piezas fundamentales para la automatización de procesos avanzados, permitiendo interacciones más inteligentes y contextualizadas.

Implementación eficiente: Optimización de recursos para escalar

El despliegue de modelos de lenguaje a gran escala exige estrategias de optimización que minimicen el consumo de recursos sin afectar el rendimiento. Técnicas como quantization, distillation y model pruning permiten reducir la carga computacional, facilitando la escalabilidad sin necesidad de infraestructuras excesivamente costosas. Estas prácticas aseguran que los modelos sean más eficientes y accesibles para su implementación en diversos entornos de producción.

Monitoreo y evaluación continua: Detección y ajuste en tiempo real

Los LLMs pueden verse afectados por la evolución de los datos a lo largo del tiempo (data drift), lo que impacta directamente en su desempeño. Para garantizar su fiabilidad, es fundamental implementar sistemas de monitoreo y evaluación continua, capaces de detectar anomalías, sesgos y degradaciones en el rendimiento. Contar con herramientas de auditoría en tiempo real permite realizar ajustes proactivos y asegurar que los modelos mantengan su calidad y precisión en producción.

Gestión del sesgo y seguridad: Control sobre los resultados generados

El uso de LLMs en entornos críticos requiere medidas para prevenir la generación de contenido no deseado o sesgado. Estrategias como la auditoría de modelos, el filtrado de datos de entrenamiento y el prompt engineering son esenciales para mitigar riesgos y garantizar que los resultados generados sean éticos, precisos y alineados con los valores de cada organización.

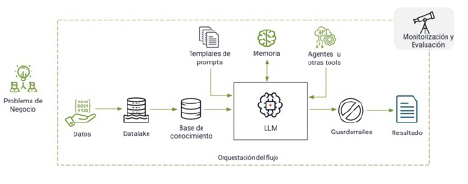

Arquitectura de un Pipeline de LLMOps: Cómo llevar la IA Generativa a Producción

Una aplicación de Generative AI va mucho más allá de un LLM; requiere una arquitectura completa basada en LLMOps para garantizar precisión, escalabilidad, seguridad y eficiencia.

A continuación, exploramos los principales componentes de un pipeline de LLMOps y cómo trabajan juntos para que la IA generativa funcione correctamente en producción.

1. Ingesta y Procesamiento de Datos

Para que un modelo de IA genere respuestas útiles, primero necesita acceso a información relevante. Esta información puede venir de diversas fuentes, como bases de datos, documentos, APIs o flujos de datos en tiempo real.

Uno de los enfoques clave en esta fase es el uso de almacenamiento de información optimizado para búsqueda semántica, lo que permite al modelo recuperar contexto de manera más eficiente y responder con mayor precisión. En lugar de depender solo de palabras clave, este tipo de almacenamiento organiza la información en una estructura que facilita la comprensión del significado detrás de los datos.

También es fundamental convertir la información en formatos que el modelo pueda procesar mejor. En este punto, entran en juego técnicas de representación de datos en forma de vectores, que ayudan a mejorar la precisión en la recuperación de información y en la generación de respuestas contextualizadas.

2. Ajuste y Optimización del Modelo

Aunque los modelos de lenguaje ya vienen entrenados con grandes volúmenes de datos, muchas veces necesitan ajustes para adaptarse a necesidades específicas, como responder preguntas técnicas sobre un producto o mantener un tono de comunicación particular.

Existen diferentes estrategias para lograr esto:

- Ajuste del modelo con datos específicos, lo que permite mejorar su desempeño en un dominio en particular.

- Optimización del diseño de las consultas (prompts) para mejorar la calidad de las respuestas sin necesidad de modificar el modelo.

- Combinación del modelo con información externa, de manera que las respuestas sean más precisas y estén basadas en datos actualizados en bases de conocimientos privadas.

3. Despliegue y Escalabilidad

No basta con tener un modelo bien ajustado; también es clave asegurarse de que pueda manejar un alto volumen de consultas sin afectar su rendimiento. Para esto, se aplican estrategias como:

- Infraestructura flexible y escalable, que permita aumentar o reducir los recursos según la demanda.

- Optimización del modelo para reducir su tamaño y consumo de cómputo, manteniendo su capacidad de respuesta.

- Uso eficiente de recursos de hardware, asegurando que el procesamiento de cada consulta sea rápido y accesible.

4. Monitorización y Seguridad

Una vez que el modelo está en producción, es fundamental asegurarse de que funciona correctamente y de manera segura. Algunas prácticas clave incluyen:

- Supervisión constante de la calidad de las respuestas, para detectar posibles errores o sesgos.

- Protección de la información sensible, evitando el uso de datos privados en la generación de respuestas.

- Controles de acceso y uso, para prevenir abusos y garantizar que la IA se utilice de manera ética a través de guardarrailes.

5. Agentes de IA y Conexión con Herramientas Externas

Un modelo de IA por sí solo puede ser útil, pero su verdadero potencial se desbloquea cuando se combina con herramientas externas mediante agentes de IA.

Los agentes de IA funcionan como orquestadores inteligentes que pueden recibir instrucciones, buscar información relevante y tomar decisiones basadas en múltiples fuentes. Estos agentes pueden:

- Llamar a APIs externas para obtener información en tiempo real.

- Conectarse con bases de datos para consultar datos específicos antes de generar respuestas.

- Ejecutar acciones en sistemas empresariales, como automatizar flujos de trabajo o actualizar registros.

- Interactuar con otras herramientas de IA, combinando modelos para tareas más complejas, como análisis de imágenes, generación de código o procesamiento de voz.

Gracias a estos agentes, la IA generativa deja de ser solo un chatbot y se convierte en una verdadera herramienta de automatización e integración con distintos ecosistemas empresariales.

Impacto y Desafíos

A medida que más empresas adoptan modelos de lenguaje a gran escala, los desafíos técnicos y operativos también crecen. La escalabilidad, la eficiencia computacional y la gestión de datos siguen siendo áreas críticas que requieren mejoras constantes. Además, el uso de RAG y AI Agents plantea preguntas sobre la transparencia y confiabilidad de las respuestas generadas.

Otro aspecto clave es la integración de modelos en flujos de trabajo empresariales sin comprometer la seguridad ni la privacidad de los datos. Asegurar que los modelos cumplan con regulaciones y estándares éticos es una tarea en constante evolución.

Conclusión

La IA generativa está redefiniendo la forma en que interactuamos con la tecnología, pero su adopción efectiva requiere metodologías avanzadas como LLMOPS. Desde fine-tuning hasta retrieval-augmented generation y AI agents, la implementación de estos enfoques marca la diferencia entre un modelo experimental y una solución robusta y escalable.

A medida que la tecnología avanza, los LLMOPS continuarán evolucionando, permitiendo que los modelos de lenguaje sean más eficientes, accesibles y confiables en múltiples aplicaciones del mundo real.

Beatriz Blanco

Vicepresidenta Comunidad AEC de Inteligencia Artificial