Dominando la IA: Conceptos Esenciales para Entender la Inteligencia Artificial

Dominando la IA: Conceptos Esenciales para Entender la Inteligencia Artificial

Comenzamos el blog de la Comunidad AEC Inteligencia Artificial (IA) con un artículo que explica, de forma conceptual y sencilla, qué es la IA, qué campos comprende y algunos habilitadores que han hecho posible la situación actual.

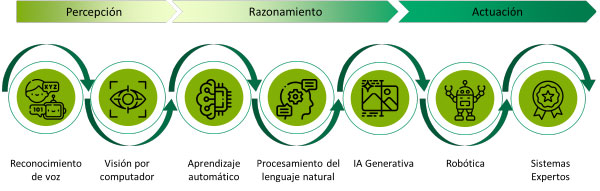

La IA es la capacidad de las máquinas para realizar tareas que normalmente requieren inteligencia humana, como la percepción, el aprendizaje y el razonamiento. En este sentido, se han ido desarrollando estas capacidades en distintas áreas de conocimiento.

En primer lugar, existen tecnologías que permiten a las máquinas tener una percepción del mundo que las rodea. Por un lado, el reconocimiento de voz les permite entender y procesar la voz y el lenguaje hablado. Por otro lado, la visión por computador las habilita para interpretar y entender imágenes y vídeos.

En segundo lugar, las máquinas necesitan razonar, tomar decisiones y aprender de los datos. Para ello se han desarrollado tres áreas de la IA:

El aprendizaje automático es la capacidad de las máquinas para aprender y reconocer patrones en un conjunto de datos y poder hacer predicciones o tomar decisiones sin ser programadas explícitamente en un nuevo conjunto de datos. Atendiendo a las formas de aprender de una máquina, cuando además de los datos de entrada se le enseña las salidas que debe predecir, se dice que el aprendizaje es supervisado; es supervisado, en el sentido que una persona procesa los datos para enseñarle ejemplos anotados y controlados. Cuando la máquina explora y descubre patrones en datos sin etiquetas, se dice que es aprendizaje no supervisado. Mientras que hay un tipo de aprendizaje, por refuerzo, que gracias a un sistema de recompensas la máquina aprende a tomar mejores decisiones gracias a la experiencia y realimentación.

El procesamiento del lenguaje natural (NLP) es el área que se encarga de comprender el lenguaje humano, analiza el significado de un documento o una conversación, hablada o escrita, la semántica y la intencionalidad del lenguaje empleado.

La IA Generativa es un subcampo de la inteligencia artificial que dota a las máquinas de la capacidad de creación. Los sistemas a través de estos algoritmos proporcionan nuevos datos (textos, música, imágenes, …) a imagen de los patrones que han aprendido en vastas cantidades de datos.

Finalmente, cuando queremos que las máquinas actúen, lo pueden hacer como sistemas expertos que utilizan el conocimiento de expertos humanos y lo codifican en reglas para tomar decisiones en áreas muy específicas, como la medicina y la ingeniería. O cuando queremos que el sistema interactúe en el mundo físico, tenemos que interseccionar el mundo de la inteligencia artificial con la con mecánica y electrónica en la robótica para realizar tareas físicas complejas y precisas.

Todos estos campos se han ido desarrollando de manera individual y en paralelo. Pero, en general, lo forman un conjunto de inteligencias artificiales débiles o estrechas. Esto consiste en algoritmos especializados que han sido entrenados para resolver cada uno una tarea. Por ejemplo, el reconocimiento de matrículas, un algoritmo de predicción de fraude fiscal, un recomendador de series de televisión o el texto predictivo del teclado, cada uno de ellos es un algoritmo diseñado, entrenado y programado por una persona para realizar su propósito específico.

Por el contrario, el concepto de Inteligencia artificial general (AGI) se refiere a un sistema con inteligencia similar a la humana y con la capacidad de autoaprendizaje. El objetivo es que el sistema pueda realizar tareas para las que no está necesariamente entrenado o desarrollado.

Pero, ¿por qué oímos tanto hablar de AGI en la actualidad? Antes de la apertura al público de ChatGPT en noviembre del 2022, nunca antes habíamos visto un algoritmo poder realizar tareas para las que no había sido explícitamente entrenado. Debido a la capacidad de los grandes modelos de lenguaje (LLMs), sistemas como ChatGPT son capaces de encontrar relaciones entre las vastas cantidades de datos que conforman su corpus de conocimiento, y no sólo han pasado el test de Turing, sino que han sorprendido con su capacidad para resumir, traducir, listar, programar y otra serie de tareas para las que no habían sido entrenados. Entonces, ¿son ChatGPT, o los modelos de los otros grandes players, una AGI? Claramente, los LLMs comprenden, son inteligentes, pero no son una inteligencia artificial general. No son inteligentes como nosotros, no tienen un pensamiento social, no imaginan el futuro, no se proyectan en él, no tienen consciencia de sí mismos, de sus actos ni de sus reflexiones. O al menos, no de momento.

La IA ha recorrido un largo camino desde sus inicios teóricos hasta convertirse en una tecnología integral que es hoy en día. Este avance no ha sido casual; ha sido el resultado de varios factores cruciales que han convergido para llevarla al punto en el que se encuentra hoy.

Uno de los pilares fundamentales que ha impulsado el avance de la IA es la abundancia de datos. En la era digital, las compañías han comenzado a digitalizar prácticamente todas sus operaciones, generando enormes cantidades de datos a cada segundo. Además, el surgimiento de internet ha facilitado una fuente inagotable de conocimiento compartido, permitiendo el acceso a información antes inimaginable.

Estos datos se dividen en dos categorías principales: estructurados y no estructurados. Los datos estructurados son aquellos que están organizados en un formato predefinido, como bases de datos y hojas de cálculo, facilitando su análisis y procesamiento. Por otro lado, los datos no estructurados no siguen una estructura específica; datos de sensores

texto, imágenes y vídeo, son los ejemplos más conocidos. Los datos son la materia prima de la IA, su calidad y capacidad de representar el problema son sus cualidades más importantes.

La anotación de datos es un proceso crítico para el aprendizaje supervisado y que el algoritmo entienda qué debe aprender. Este proceso es extremadamente laborioso, especialmente cuando se trata de grandes volúmenes de datos, juegos como Quick, Draw!, los captcha y las redes sociales han permitido que los ingenieros de IA e investigadores obtuvieran grandes cantidades de datos anotados, acelerando enormemente el proceso y aumentando la diversidad y precisión de las etiquetas. Muchos becarios en laboratorios de investigación han ayudado enormemente en este proceso, breve mención a estos héroes anónimos.

Las redes neuronales profundas, o deep learning, son un subcampo del aprendizaje automático y representan un salto significativo en la capacidad de los algoritmos de IA. Inspiradas en la estructura y funcionamiento del cerebro humano, estas redes están compuestas por múltiples capas de neuronas artificiales que procesan la información de manera jerárquica. Los conjuntos de datos activan distintas capas y generan conexiones entre sus perceptrones y han permitido niveles de precisión y rendimiento sin precedentes.

El siguiente habilitador es la capacidad de cómputo. En los primeros días de la IA, las limitaciones de hardware eran un gran obstáculo. Sin embargo, la aparición y evolución de las Unidades de Procesamiento Gráfico (GPUs) han transformado el panorama. Las GPUs, originalmente diseñadas para renderizar gráficos en videojuegos, resultaron ser extremadamente eficientes para las operaciones matemáticas necesarias en el entrenamiento de modelos de IA, especialmente en redes neuronales profundas. La capacidad de realizar cálculos paralelos ha permitido reducir drásticamente los tiempos de entrenamiento y ha habilitado el desarrollo de modelos cada vez más complejos.

Una tecnología emergente que ofrece promesas de un mayor rendimiento en el campo de la inteligencia artificial es la computación cuántica. Aunque los ordenadores cuánticos aún se encuentran en una fase muy inmadura, se tienen resultados teóricos e incluso algunas evidencias experimentales que indican que modelos como los de las redes neuronales cuánticas o las máquinas cuánticas de vectores de soporte podrían llegar a mejorar el rendimiento de los sistemas de aprendizaje automático, mejorando su precisión y aprendiendo más rápido y con menos datos.

Finalmente, la proliferación de frameworks de código abierto ha democratizado el acceso al desarrollo de IA. Herramientas como TensorFlow, PyTorch, Keras y Caffe han proporcionado plataformas robustas y accesibles para investigadores, desarrolladores y empresas de todo el mundo. Estos frameworks fomentan la inteligencia colectiva, la colaboración y el intercambio a través de comunidades abiertas, lo cual ha acelerado significativamente el progreso en el campo de la IA.

Con una base sólida de datos abundantes, capacidades de cómputo avanzadas, redes neuronales profundas y herramientas accesibles, la inteligencia artificial emerge como una fuerza transformadora que redefine nuestro trabajo, nuestra vida cotidiana y la estructura misma de nuestras sociedades, cambiando de manera fundamental cómo interactuamos, cómo tomamos decisiones y cómo miramos hacia el futuro.